废电脑回收:基于可变步长的多通道主动噪声控制算法

- 电子产品

- 2021-09-03

- 349

- 更新:2021-09-03 08:50:50

编者按为了得到更好的噪声控制效果,提出一种基于可变步长的多通道主动噪声控制算法。此控制算法由广泛使用的FxLMS算法改进而来。首先将收敛步长从固定值优化为可变收敛步长从而优化收敛过程,使算法在保持较快的收敛速度的同时达到更低的稳态误差。进一步将算法扩展成为多通道控制算法来达到全局降噪的目的。仿真实验结果表明,本文提出的控制方法对比常用FxLMS控制算法、NFxLMS算法和SVSLMS算法在收敛速度和减小稳态误差方面有非常大的提高,并且在大区域噪声控制方面能起到一定的效果。

0引言

所有的声音均是由一系列不同频率的声信号混合而成,如果可以人为地生成一种声音,其频率与所要消除的噪声完全一样,只是相位与之相反就可以将这噪声完全抵消掉。主动噪声控制(ANC)就是在设备中加入了对噪声分析的电路,并通过控制器快速运算分析,产生可以抵消外界噪声的人为声信号,通过扬声器将相反相位的信号播放后抵消目标噪声。ANC可用于多种应用,包括个人听力设备[1-2],管道和室内声学增强,发动机排气噪声抑制以及改善车辆外壳风噪,飞机舱和振动机器中的声学[3-4]。随着现代工业的飞速发展,大部分工业设备的功率越来越大,转速越来越快,噪声危害也日益突出。噪声不仅影响产品质量、操作精度、缩短产品寿命、危及安全性,且污染环境、影响人生健康。因此,掌握噪声控制技术是工业发展面临的重大课题。

在实际研究应用中,滤波x最小均方算法(filteredxLMS,FxLMS)[5]结构简单、算法稳定,所以FxLMS算法在ANC控制器中使用最为广泛;还有改进而成的归一化LMS[6],其稳态误差可以降低到很小,但是收敛速度会受到很大影响;基于Sigmoid函数的SVSLMS[7]算法也被广泛应用,其收敛速度较快但是稳态误差又达不到要求。此类变步长控制算法[8-11]的主要问题在于算法中收敛步长多数是反馈误差信号的函数。经滤波器迭代计算后,该信号收敛不为零,会致使系统出现非零失调问题,则容易导致系统进入稳态后的误差仍然较大,且不再收敛。因此通过构建前馈信号的相关函数为参考的变步长主动噪声控制系统,来提高低频噪声降噪效果成为了可行的方向。

在自由场中,单通道主动噪声控制系统产生的“消音区”的直径约为控制声波波长的1/10[12],也就是说常规单通道主动控制系统的有效范围只有直径二三十厘米,这对于实际应用来说是远远不够的。因此大区域噪声主动控制需要使用多通道控制算法来实现[13-17],为此本文提出一种基于可变步长的多通道主动控制算法,并利用仿真实验验证其可行性。

作者简介王宁(1995—),硕士生,主要研究方向为列车及汽车车辆主动噪声控制技术研究,E-mailningwang5279@163.com。

贺钰瑶(1997—),硕士生,主要研究方向为基于神经网络的主动噪声控制技术研究,E-mail458310644@163.com。

1控制算法

1.1可变步长

当采用定收敛步长时,系统的收敛精度和收敛时间呈现出对立的情况,即收敛步长设置较小时,收敛精度更高,但是收敛时间却大大延长;反之,收敛步长设置较大时,收敛时间减小,但是收敛精度大为降低。因此,

为了消除定收敛步长FxLMS的局限性,考虑采用可变收敛步长FxLMS算法。

基于Sigmiod函数的可变收敛步长算法(SVSLMS)中

由式(1)知,可变收敛步长μ(n)是e(n)的Sigmiod函数。初始收敛时,误差较大则收敛因子取值也较大;随着误差的逐渐变小,则收敛因子取值也随之变小。从而同时满足了自适应滤波的准则较快的收敛速度、跟踪速度以及较小的稳态误差。但此式计算时较为繁琐,同时误差e(n)在0附近的稳定性不够理想,易引起非零失调。归一化LMS算法中可变步长用参考输入信号的功率值进行归一化处理,从而得到与参考输入信号功率有关的可变收敛步长μ。可变收敛因子函数表示为

由于x(n)的欧式平方范数的硬件实现较为复杂,且参考输入信号只取当前瞬时值,x(n)的欧式平方范数即等于x(n)的绝对值平方,即改进为

其中,|x(n)|2是第n次迭代中的瞬时参考输入信号的平方值。由式(1)、式(3)可知,将可变收敛因子的计算中由原求解输入向量的自相关矩阵的运算,变换为标量的平方值运算,可提高收敛性,故令

为改善非零失调的问题,将可变步长的输入信号改为系统参考信号的变化量,可得

1.2多通道可变步长

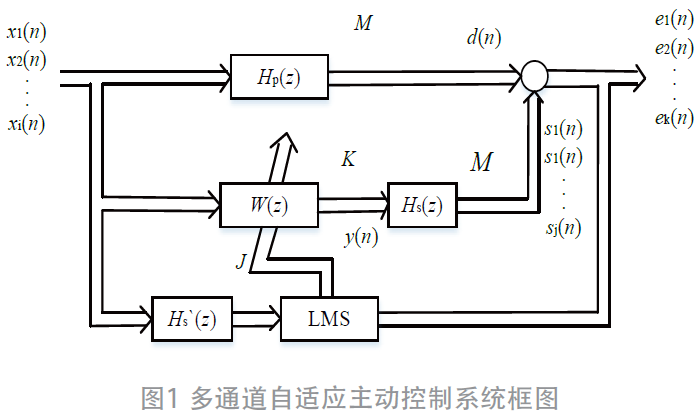

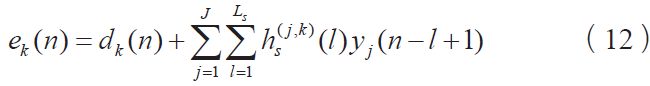

MIMO滤波-xLMS算法是应用最为广泛的噪声控制算法,系统框图如图1所示。设系统中有I个参考传感器,J个次级扬声器,K个误差传感器。IJ个自适应滤波器采用横向滤波器,其长度为L,滤波器权系数采用矢量形式统一表示为W(z)。Hp(z)代表IK个初级通路的传递函数,Hs(z)代表JK个次级通路的传递函数,Hs`(z)是次级通路传递函数的估计值。初级通路和次级通路等效为FIR滤波器,假设其长度分别为Lp和Ls。

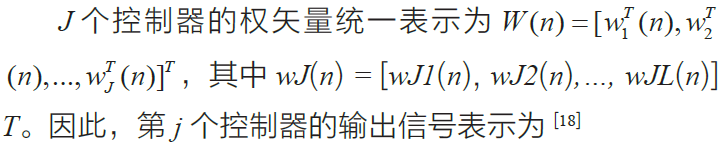

设xi(n)为第i个参考传感器在第n时刻的输入信号,称为第i个参考信号,即为xi(n)=[xi(n),xi(n-1),…,xi(n-L+1)]T;yj(n)为第j个控制器在第n时刻的输出信号,表示为y(n)=[y1(n),y2(n),…,yJ(n)]T;dk(n)为第k个误差传感器处第n时刻的期望信号,表示为d(n)=[d1(n),d2(n),…,dK(n)]T;ek(n)为该处第n时刻的误差项信号表示为e(n)=[e1(n),e2(n),…,eK(n)]T。

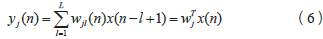

则第j个扬声器的输出信号即为sj(n)=yj(n)×Hs(n)。误差信号矢量可写成

式中Hs(n)为K×J阶次级通路脉冲响应矩阵,第(k,j)元素为hskj(n);r(n)为J×KLs阶滤波-x信号矩阵,其(j,k)元素为

![]()

设多通道自适应主动控制系统的目标函数为

与常用FxLMS算法类似,利用最陡下降法原理,可以推导出控制器权系数迭代公式为

w(n+1)=w(n)2μr(n)e(n)(10)

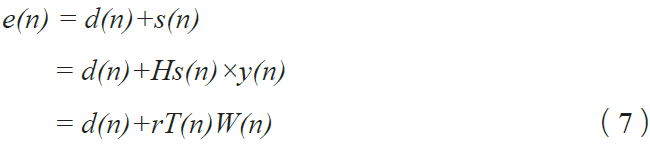

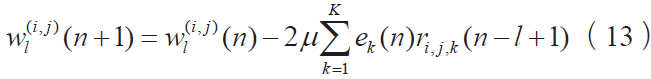

整个算法表达式总结如式(11)~(13)所示

第k个误差传感器接收到的信号为

第i个参考传感器至第j个控制器的权系数迭代公式

式中

其中μ为收敛步长,可由式(5)得到。则此算法命名为可变步长多通道滤波x最小均方算法(VM-FxLMS)。

2仿真实验

2.1单通道算法性能

在MATLAB中建立ANC系统模型,信号模拟排风扇噪声。风扇噪声由旋转噪声和絮流噪声组成,旋转噪声用正弦信号代表,频率为500Hz左右,絮流噪声用白噪声代表,截至频率为4kHz。在系统中加入低通滤波器,将高于4kHz的噪声滤除。

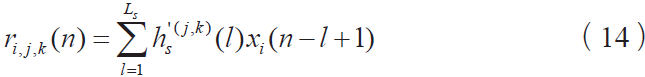

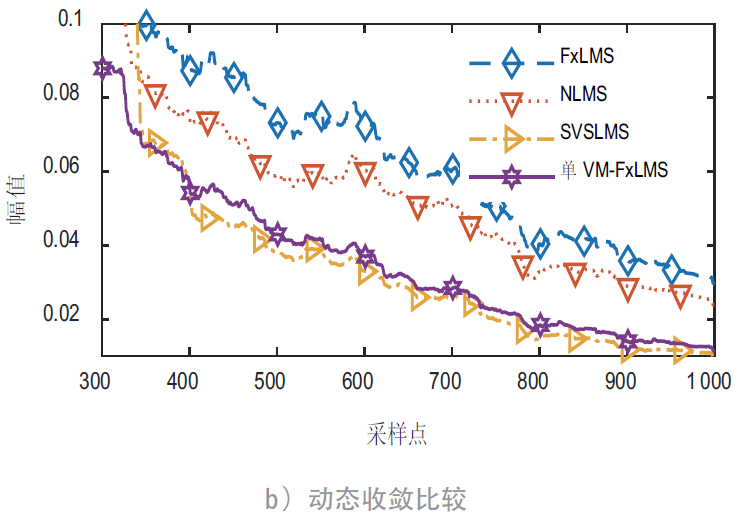

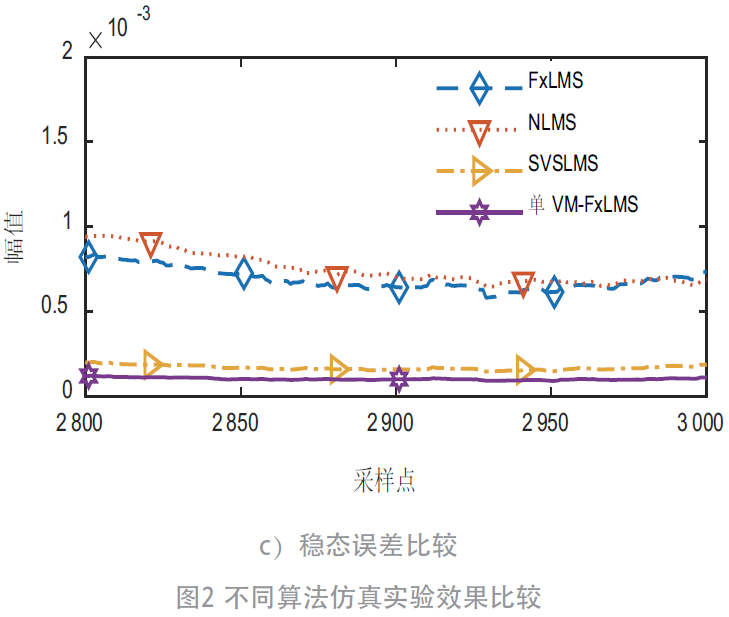

下面将分别使用FxLMS算法、归一化NLMS算法、SVSLMS算法和本文提出的单VM-FxLMS算法针对此模拟噪声进行测试对比。三种算法初始收敛步长μ均设为0.01。仿真测试结果如图2所示。

初始收敛状态时,从图2a)和b)可看出,可变步长算法的收敛速度比定步长算法有着明显优势。本文提出的单VM-FxLMS算法的收敛速度很快,且在其他算法趋于稳定时本算法还能够进一步收敛。在稳态阶段,从图2c)中可看出,单VM-FxLMS算法稳态误差最低,且平稳无明显波动。从此仿真结果可看出,本文所提出的算法优于传统的定步长FxLMS算法和一些其他的变步长算法。

2.2多通道区域降噪实现

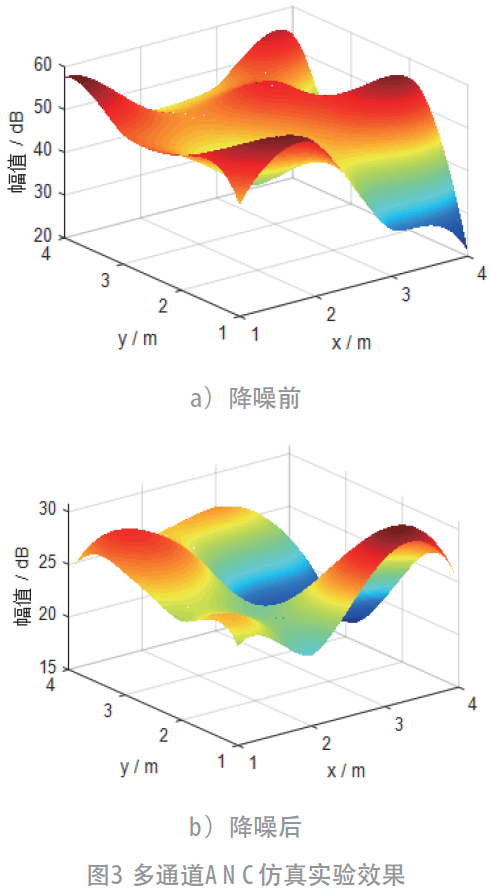

在MATLAB中模拟4m×4m大小的区域,在区域内设置多个噪声源,噪声成分同2.1节所设噪声源且增加更多的干扰。初始收敛步长μ均设为0.01,多通道ANC系统设置为16通道。在此区域降噪前和降噪后的噪声仿真图如图3所示。

如图3a)所示,此区域中平均噪声约为50dB,最高点噪声约为60dB。降噪后的仿真图如图3b)所示,除个别点之外,整个区域的噪声有非常明显的降低,平均剩余噪声约为25dB。降噪后相比于降噪前,噪声降低了约25dB,个别区域是有噪声升高的现象。此仿真实验表明,本文提出的多通道ANC系统对区域降噪具有非常好的控制些效果。

3结语

本文提出的基于可变步长的多通道噪声主动控制方法以参考信号的变化量作为可变步长函数的输入信号,能够改善算法非零失调的状况,对比于其他常用的控制算法,在收敛速度与收敛效果上有明显优势。然后将可变步长算法扩展至多通道主动控制算法,对于大区域的噪声控制的仿真当中,多通道ANC系统表现出了非常好的降噪效果。同时,多通道ANC系统的计算量是一个需要进一步研究的重点,这也是未来研究工作的重点。

上一篇:二手旧家具回收:西安家具城大明宫

下一篇:机房空调关闭时 散热怎么办?